一起草CNN:探索卷积神经网络的无限可能

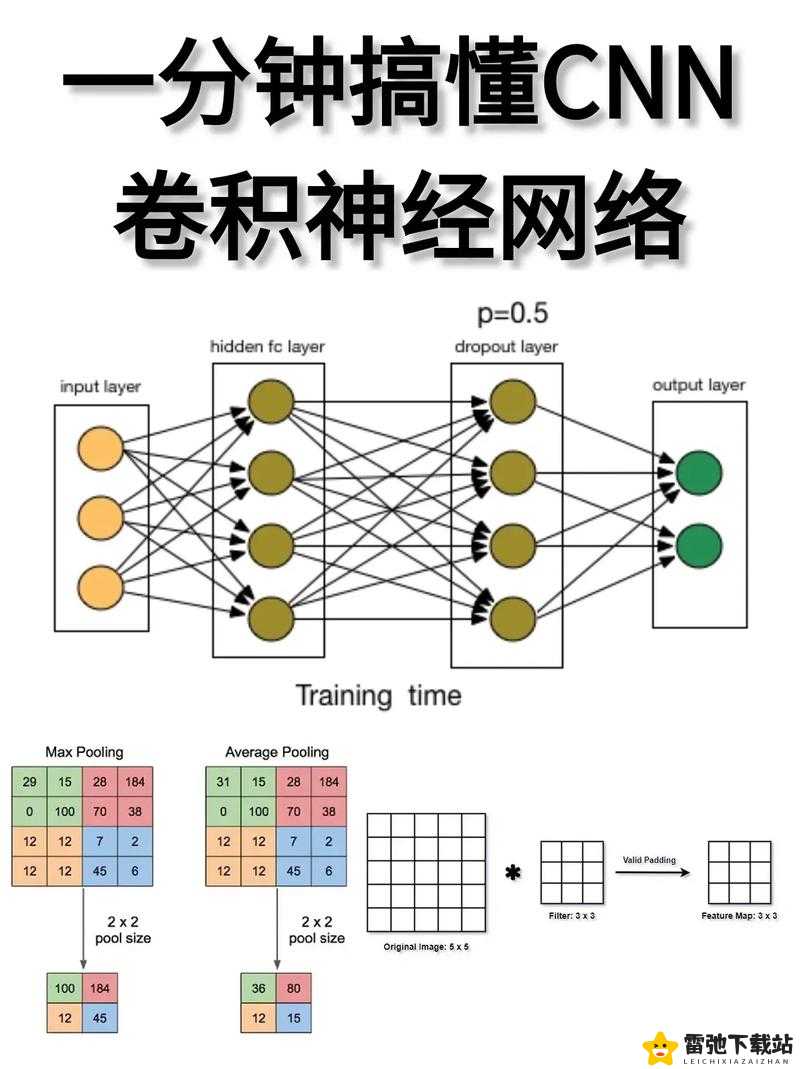

卷积神经网络(Convolutional Neural Network,简称CNN)是一种深度学习模型,主要用于处理图像、视频等数据。CNN通过模拟人类视觉系统的结构,逐层提取图像的特征。CNN通过卷积层进行特征提取,这里的卷积操作类似于图像处理中的滤波器,可以捕捉到图像中的边缘、纹理等低级特征。接着,通过池化层(Pooling Layer)进行降维和特征选择,减少计算量并保持重要的特征。通过全连接层(Fully Connected Layer)进行分类或回归任务。CNN的设计使得它在图像识别、物体检测等任务中表现出色。

卷积层的核心是卷积核(Kernel或Filter),它是一个小型的矩阵,用于在图像上滑动并进行卷积操作。卷积核的大小、步长和填充方式都会影响输出特征图的尺寸和特征提取的效果。例如,3x3的卷积核可以捕捉到更细微的特征,而5x5的卷积核则可能捕捉到更大范围的特征。步长(Stride)决定了卷积核在图像上的移动速度,较大的步长会使输出特征图更小,减少计算量但也可能丢失一些信息。填充(Padding)则是在图像边缘添加零值,使得卷积后的特征图尺寸保持不变或减小得较少,保留更多边缘信息。

池化层通常采用最大池化(Max Pooling)或平均池化(Average Pooling)。最大池化通过取局部区域的最大值来减少特征图的尺寸,保留最显著的特征;平均池化则通过取局部区域的平均值来平滑特征图。池化层的作用不仅在于降维,还能提供一定程度的平移不变性,即对图像中的小幅度平移不敏感,从而提高模型的鲁棒性。

二、CNN的训练过程

CNN的训练过程包括前向传播和反向传播。前向传播中,输入图像通过网络层逐层处理,生成预测结果。反向传播则通过计算损失函数(如交叉熵损失或均方误差)的梯度,利用链式法则逐层传递误差信号,更新网络参数。训练过程中,常用的优化算法包括随机梯度下降(SGD)、Adam等,这些算法通过调整学习率来优化网络参数,使得模型在训练数据上表现更好。

在训练过程中,数据增强(Data Augmentation)是一种常用的技巧,通过对训练图像进行旋转、翻转、裁剪、缩放等操作,增加数据的多样性,防止模型过拟合。数据增强可以模拟现实世界中的各种变化,使得模型在面对不同环境下的图像时表现更稳定。

批量归一化(Batch Normalization,BN)是另一种提高训练效率和稳定性的方法。BN通过在每个批次(Batch)内对特征进行标准化处理,减小内部协变量偏移(Internal Covariate Shift),从而加速训练过程,减少对初始参数的敏感性,提升模型的泛化能力。

三、CNN的应用领域

CNN在计算机视觉领域有着广泛的应用。图像分类是CNN最基础的应用之一,通过训练模型识别图像中的物体类别,如猫狗识别、交通标志识别等。物体检测任务则更进一步,不仅识别物体,还要定位物体的位置,如YOLO、SSD等算法利用CNN进行快速准确的物体检测。

图像分割是CNN在医学影像分析中的重要应用,通过像素级别的分类,将图像分割成不同的区域,识别出病变部位。语义分割模型如U-Net、DeepLab等在医学影像分析中表现出色。CNN还用于生成对抗网络(GAN)中,生成高质量的图像、进行图像风格迁移等创新应用。

四、CNN的未来发展

随着计算能力的提升和数据量的增加,CNN的架构也在不断演进。轻量化网络如MobileNet、ShuffleNet等,旨在减少参数量和计算量,适用于移动设备和嵌入式系统。注意力机制(Attention Mechanism)被引入CNN中,如SENet,通过动态调整特征图的权重,提升模型的表达能力。

CNN与其他深度学习模型的融合,如结合循环神经网络(RNN)用于视频分析,结合强化学习用于智能决策等,都在拓展CNN的应用边界。未来,CNN将继续在更复杂的视觉任务中发挥关键作用,同时也将在其他领域如自然语言处理、语音识别等方面展示其潜力。